本記事では、Lambda Diffusersを用いてテキストからポケモン風の画像を生成する方法をご紹介します。

|

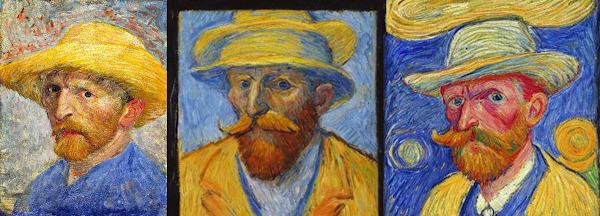

| 出典: LambdaLabsML/lambda-diffusers |

Stable Diffusion fine tuned on Pokémon

概要

近年良くも悪くも注目を集めるStable Diffusionですが、Stable Diffusion fine

tuned on PokémonはLambdaLabsがポケモンの画像とキャプションからなるデータセットを用いてStable DiffusionをFine Tuningしたモデルです。

このモデルはHuggingFaceから取得することができ、任意のテキストを入力すると上記の画像のようにポケモン風画像が生成されます。

なおStable Diffusionの技術解説は以下の記事をご参照ください。

Stable Diffusionを用いて画像生成・画像修復するレシピ

本記事では上記手法を用いて、任意のテキストからポケモン風画像を生成するとともに、LambdaLabsが公開するその他のモデルを動かしていきます。

デモ(Colaboratory)

それでは、実際に動かしながらLambdaLabsが公開するStable Diffusionモデルを試していきます。

ソースコードは本記事にも記載していますが、下記のGitHubでも取得可能です。

GitHub - Colaboratory demo

また、下記から直接Google Colaboratoryで開くこともできます。

なお、このデモはPythonで実装しています。

Pythonの実装に不安がある方、Pythonを使った機械学習について詳しく勉強したい方は、以下の書籍やオンライン講座などがおすすめです。

おすすめの書籍

[初心者向け] Pythonで機械学習を始めるまでに読んだおすすめ書籍一覧

本記事では、現役機械学習エンジニアとして働く筆者が実際に読んだ書籍の中でおすすめの書籍をレベル別に紹介しています。

おすすめのオンライン講座

[初心者向け] 機械学習がゼロから分かるおすすめオンライン講座

本記事では、機械学習エンジニアとして働く筆者が、AI・機械学習をまったく知らない方でも取り組みやすいおすすめのオンライン講座をご紹介しています。

環境セットアップ

それではセットアップしていきます。 Colaboratoryを開いたら下記を設定しGPUを使用するようにしてください。

初めにGithubからソースコードを取得します。

次にライブラリをインストールします。

インストール完了後、一度ランタイムを再起動します。

最後にライブラリをインポートします。

以上で環境セットアップは完了です。

Image to Image

まずテキストからポケモン風画像を生成する前に、LambdaLabsが公開する別のモデルを用いて、Image

to Imageを動かしていきます。

このモデルは入力画像を変化させいくつかのバリエーション画像を出力します。

まずは学習済みモデルをロードします。

次に、入力画像をセットアップし、Image to Imageを実行します。

出力結果は以下の通りです。

左の画像が出力結果で、中央と右側がモデルによって変化させた画像です。

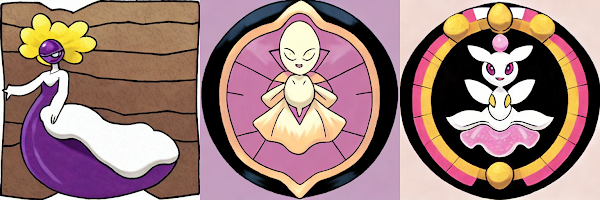

Pokemon Text to Image

続いて本題のPokemon Text to Imageを動かしていきます。

先ほどと同様にHuggingFaceから学習済みモデルをセットアップします。

続いて、テキスト(Prompt)を設定します。

それでは、テキストを入力し画像を生成してみます。

出力結果は以下の通りです。

Oda Nobunaga

その他の結果も見てみます。

Birth of Venus

Abraham Lincoln

まとめ

本記事では、FineTuneされたStable Diffusionでテキストからポケモン風画像を生成する方法をご紹介しました。

Stable Diffusion関連技術の発達は目覚ましく日々新しいモデルやサービスが生まれています。

楽しみながら追いかけていきたいです。

また本記事では、機械学習を動かすことにフォーカスしてご紹介しました。

もう少し学術的に体系立てて学びたいという方には以下の書籍などがお勧めです。ぜひご一読下さい。

また動かせるだけから理解して応用できるエンジニアの足掛かりに下記のUdemyなどもお勧めです。

0 件のコメント :

コメントを投稿