本記事では、FastComposerと呼ばれる機械学習手法を用いて、任意の2人の人物を含めた画像をテキストから生成する方法をご紹介します。

|

| 出典: mit-han-lab/fastcomposer |

FastComposer

概要

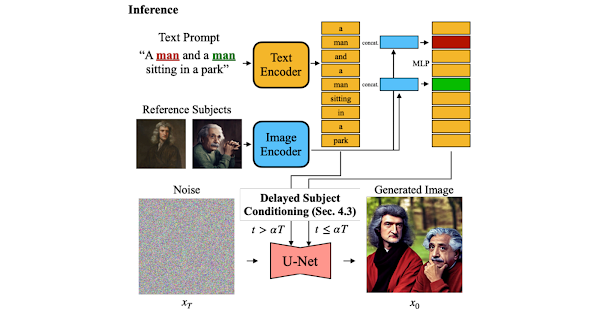

FastComposerは、モデルの追加トレーニングなく、複数のSubjectに効率的にパーソナライズするText to Image技術です。

上図を例にとると、Referencesの2人の人物画とテキストを参照し、画像を生成した結果が示されています。

FastComposerは、モデルの微調整なしに、他の手法相当の出力結果を得られることが確認できます。

従来手法はSubject固有の微調整が必要であり非効率であることや、Subject間の特徴を混合することが多く、複数のSubjectの生成に課題がありました。

FastComposerは、Image Encoderによって抽出されたSubjectのembedingsを抽出し、Diffusionモデルのテキスト条件付けを強化し、forward-passのみでSubjectの画像とテキストに基づいてパーソナライズされた画像を生成することを可能にしています。

|

| 出典: FastComposer: Tuning-Free Multi-Subject Image Generation with Localized Attention |

詳細はこちらの論文をご参照ください。

本記事では上記手法を用いて、任意の2画像をとテキストを用いて画像を生成していきます。

デモ(Colaboratory)

それでは、実際に動かしながら

ソースコードは本記事にも記載していますが、下記のGitHubでも取得可能です。

GitHub - Colaboratory demo

また、下記から直接Google Colaboratoryで開くこともできます。

なお、このデモはPythonで実装しています。

Pythonの実装に不安がある方、Pythonを使った機械学習について詳しく勉強したい方は、以下の書籍やオンライン講座などがおすすめです。

おすすめの書籍

[初心者向け] Pythonで機械学習を始めるまでに読んだおすすめ書籍一覧

本記事では、現役機械学習エンジニアとして働く筆者が実際に読んだ書籍の中でおすすめの書籍をレベル別に紹介しています。

おすすめのオンライン講座

[初心者向け] 機械学習がゼロから分かるおすすめオンライン講座

本記事では、機械学習エンジニアとして働く筆者が、AI・機械学習をまったく知らない方でも取り組みやすいおすすめのオンライン講座をご紹介しています。

環境セットアップ

それではセットアップしていきます。 Colaboratoryを開いたら下記を設定しGPUを使用するようにしてください。

初めにGithubからソースコードを取得します。

次にライブラリをインストールします。

以上で環境セットアップは完了です。

学習済みモデルのセットアップ

ここでは、論文発表元が公開している学習済みモデルをダウンロードします。

参照画像のセットアップ

ここでは、パーソナライズした画像を生成するための参照画像をWeb上から取得します。

以下で取得している画像はコード中のURLからご確認ください。

Text to Image

最後に、テキストと参照画像から、パーソナライズした画像を生成していきます。

まず、Google Colabで実行するため一部ソースコードを修正します。

それでは、実行します。

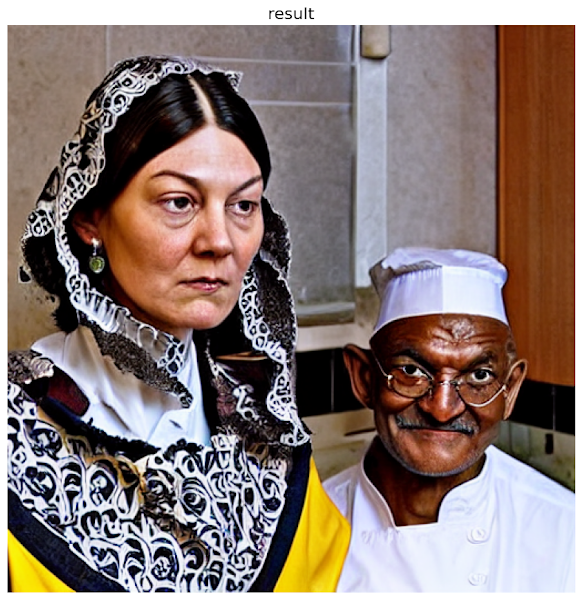

出力結果は以下の通りです。

参照画像の2画像と、テキストからパーソナライズした画像が生成できていることが確認できます。

まとめ

本記事では、FastComposerを用いてパーソナライズしたText to Imageを行う方法をご紹介しました。

出力画像の複数の人物をパーソナライズできることで、より意図する画像が生成することが可能となります。

また本記事では、機械学習を動かすことにフォーカスしてご紹介しました。

もう少し学術的に体系立てて学びたいという方には以下の書籍などがお勧めです。ぜひご一読下さい。

また動かせるだけから理解して応用できるエンジニアの足掛かりに下記のUdemyなどもお勧めです。

参考文献

1. 論文 - FastComposer: Tuning-Free Multi-Subject Image Generation with Localized Attention

0 件のコメント :

コメントを投稿